10.3 Test “post-hoc”

Lorsque nous rejetons \(H_0\) dans l’ANOVA comme dans le cas de notre exemple, nous savons qu’il y a au moins deux moyennes qui diffèrent l’une de l’autre, mais nous ne savons pas lesquelles. Notre analyse n’est pas terminée. Nous allons revisiter les tests de comparaison multiples deux à deux, mais en prenant des précautions particulières pour éviter l’inflation du risque d’erreur.

Tout d’abord, nous mettons en place un garde-fou. Nous effectuons toujours une ANOVA en premier lieu, et nous n’envisageons les comparaisons multiples que lorsque \(H_0\) est rejetée. Cela évite beaucoup de faux positifs. On appelle cela des tests “post hoc” car ils ne sont pas planifiés d’emblée, mais suivent un conclusion préalable (ici, le rejet de \(H_0\) dans un test ANOVA).

Une approche simple consisterait à modifier notre seuil \(\alpha\) pour chaque test individuel vers le bas afin que le risque de se tromper dans au moins un des tests ne dépasse pas la valeur de \(/alpha\) que nous nous sommes fixée. C’est la correction de Bonferroni. Elle consiste à diviser la valeur de \(/alpha\) par le nombre de tests simultanés nécessaires, et d’utiliser cette valeur corrigée comme seuil \(\alpha\) de chaque test de Student individuel. Dans le cas de quatre populations, nous avons vu qu’il y a six comparaisons multiples deux à deux. Donc, en appliquant un seuil corrigé de \(\alpha/6 = 0,05 / 6 = 0,00833\) pour chaque test, on aura la probabilité suivante pour \(1 - \alpha\) :

\[(1 - 0,05/6)^6 = 0,951\]

Donc, le risque global pour l’ensemble des six tests est bien de 1 - 0,951 = 0,049, soit 5%. Si elle a le mérite d’être simple, cette façon de faire n’est pas considérée comme la plus efficace. Actuellement, la méthode HSD de Tukey est préférée. HSD veut dire “Honest Significant Difference”. La technique consiste à calculer l’écart minimal des moyennes pour considérer qu’elles sont significativement différentes l’une de l’autre. Ensuite, pour chaque comparaison deux à deux, l’écart entre les moyennes est comparée à cette valeur de référence50. Le test de comparaisons multiples de Tukey est accessible à partir des “snippets” dans la SciViews Box (.hm pour le menu hypothesis tests: means, puis anova - multiple comparisons). Nous obtenons à la fois une version textuelle et une version graphique qui résume les comparaisons.

#

# Simultaneous Tests for General Linear Hypotheses

#

# Multiple Comparisons of Means: Tukey Contrasts

#

#

# Fit: lm(formula = aspect5 ~ group, data = crabs2)

#

# Linear Hypotheses:

# Estimate Std. Error t value Pr(>|t|)

# B-M - B-F == 0 -0.0036378 0.0002538 -14.331 < 0.001 ***

# O-F - B-F == 0 0.0008441 0.0002538 3.326 0.00565 **

# O-M - B-F == 0 -0.0029979 0.0002538 -11.810 < 0.001 ***

# O-F - B-M == 0 0.0044820 0.0002538 17.657 < 0.001 ***

# O-M - B-M == 0 0.0006399 0.0002538 2.521 0.05981 .

# O-M - O-F == 0 -0.0038420 0.0002538 -15.136 < 0.001 ***

# ---

# Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

# (Adjusted p values reported -- single-step method)

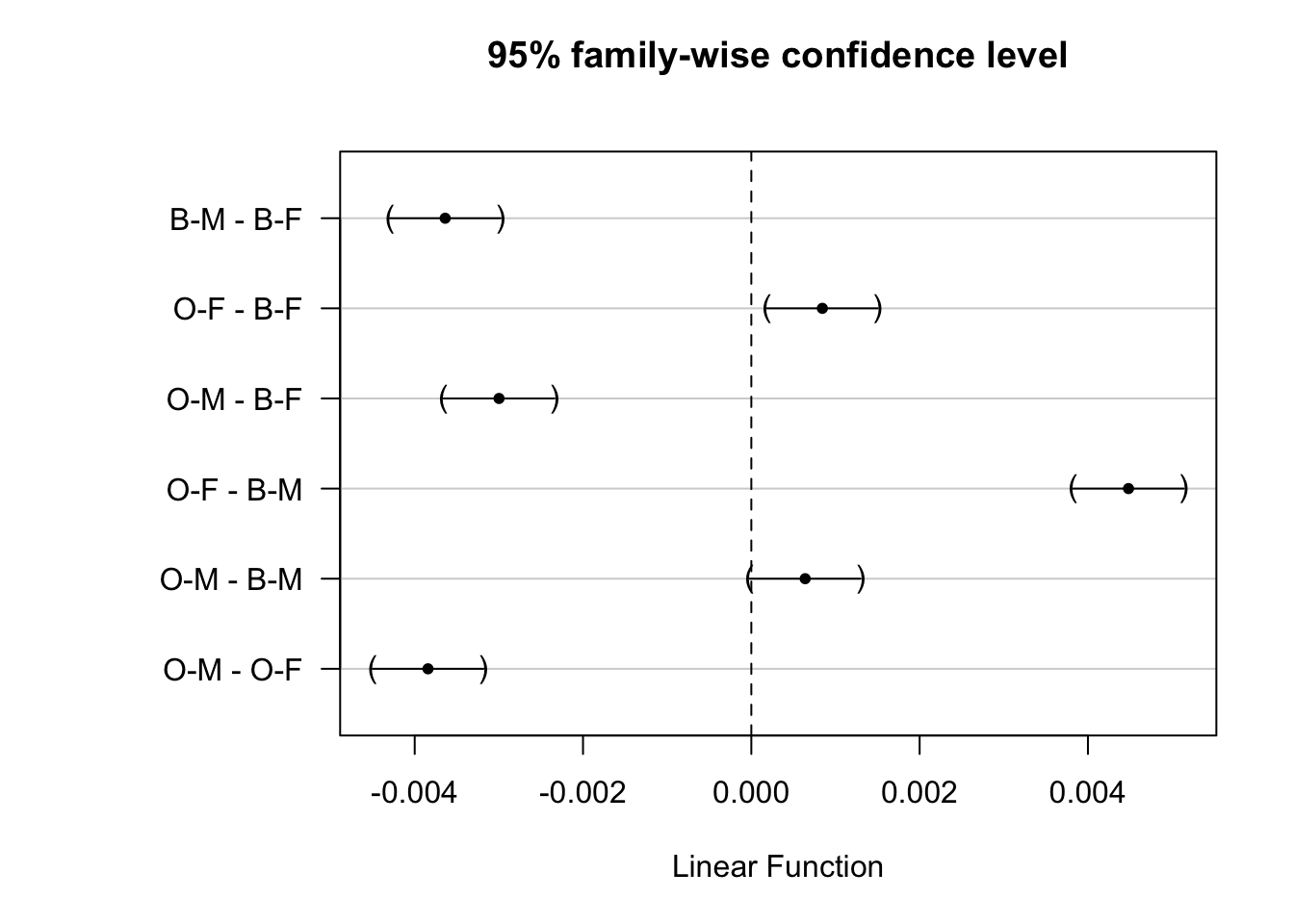

Si nous gardons notre seuil \(\alpha\) de 5%, seuls les mâles ne diffèrent (tout juste) pas entre eux (`O-M - B-M) avec une valeur P de 6%. Toutes les autres comparaisons deux à deux sont significativement différentes. Sur le graphique, si les intervalles autour des différences de moyennes comprennent zéro, matérialisé par un trait pointillé vertical, les différences ne sont pas significatives.

En conclusion, tous les groupes diffèrent de manière significative sauf les mâles (test HSD de Tukey, valeur P < 5%).

Conditions d’application

Les conditions d’application pour le test post hoc de Tukey sont les mêmes que pour l’ANOVA.

À vous de jouer !

Effectuez maintenant les exercices du tutoriel A10La_anova (L’ANOVA et tests post-hoc).

BioDataScience1::run("A10La_anova")